Wer sich für künstliche Intelligenz interessiert, hat in letzter Zeit sicher auch schon von DeepSeek gehört. Eine chinesische Firma hat DeepSeek entwickelt und als freie Software veröffentlicht. Angeblich ist die Software – Entschuldigung, KI, um einiges besser als die beste von OpenAI – also die Entwickler von ChatGPT. Eines muss man aber gleich hinzusagen – DeepSeek hat auch einen Nachteil – wenn es um China geht, ist diese Software stark zensiert.

Vorbereitungen treffen und DeepSeek installieren, auf dem Terminal nutzen

Haben Sie bereits Ollama installiert, können Sie dies weglassen. Ich beschreibe die Installation hier unter auf Debian basierenden Linux-Distributionen, also Debian, Ubuntu, Linux Mint und so weiter – unter anderen Distributionen müssen Sie eben deren Paket-Manager benutzen.

Als Erstes installieren wir über die Paket-Verwaltung die nötigen Pakete, über Synaptic oder gleich als root am Terminal:

apt update

apt install git curlAnschließend installieren wir Ollama auf dem Terminal, nutzen Sie nicht den Befehl sudo, um an administrative Rechte zu kommen, melden Sie sich zuvor mit su an:

curl -fsSL https://ollama.com/install.sh | shJetzt starten wir erst einmal die Grundlage für DeepSeek (und andere KIs unter Linux), als root am Terminal:

systemctl start ollamaMöchten Sie, dass die Software automatisch mit dem System startet:

systemctl enable --now ollamaJetzt ist es so weit, wir können DeepSeek installieren, im Beispiel die Version „deepseek-r1:7b„, als normaler Benutzer am Terminal (alle Versionen finden Sie auf GitHub, oder Sie suchen in der gewünschten Suchmaschine nach den Begriffen „ollama deepseek“):

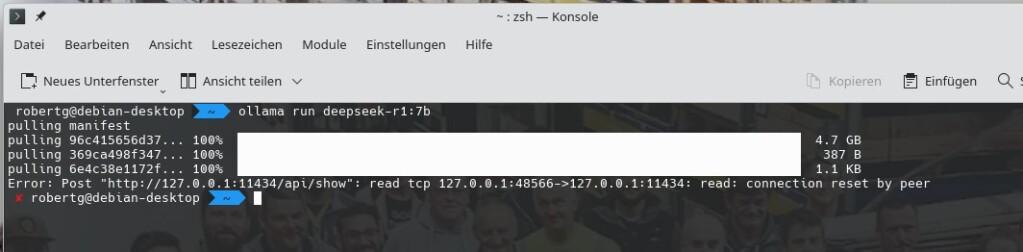

ollama run deepseek-r1:7bDer Download dauert etwas, im Moment hat DeepSeek etwa 4,7 Gigabyte:

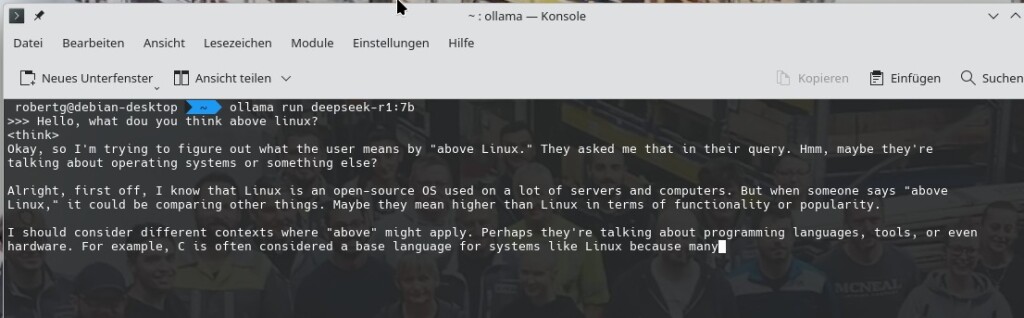

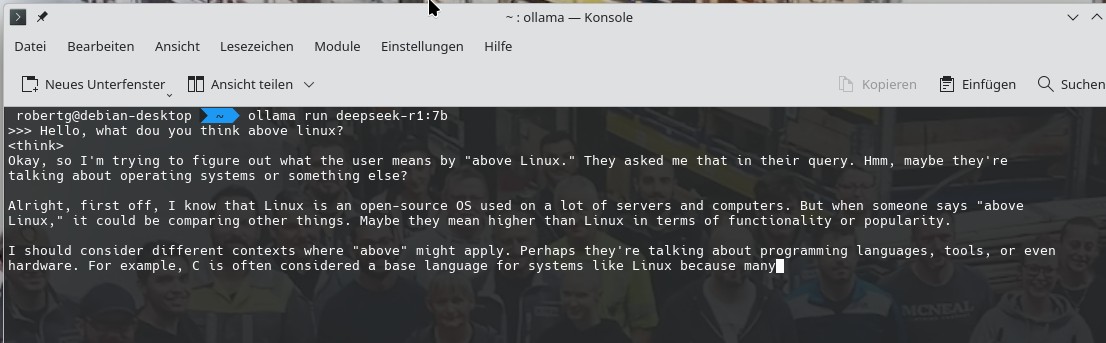

Jetzt läuft die Software bereits am Terminal und Sie können mit ihr kommunizieren:

Mit Strg+d beenden Sie die Software, starten diese wieder mit:

ollama run deepseek-r1:7b

7 Reaktionen

Hallo,

DeepSeek versteht sowohl Deutsch und spricht auch Deutsch.Er kann sogar vom Deutschen ins Türkische übersetzen…

Danke, hab ich noch nicht versucht

Was heißt spricht auch Deutsch?

Ich habe eine auf Deutsch gestellte Frage in Englisch beantwortet bekommen.

Wie kann ich eine deutschsprachige Antwort einstellen?

Hallo,

ganz einfach: ich habe mich auf der CHatseite von DeepSeek angemeldet (https://chat.deepseek.com/)

Dort,aber auch in der Smartphone App von Android kann ich DeepSeek jede Frage auf Deutsch stellen,und er antwortet auch in Deutsch.Da ich türkische Wurzeln habe,habe ich auch eine Deutsche Frage auf türkisch antworten lassen.Hat er auch sehr gut gelöst.

Mein Standort ist Deutschland,ich weiß nicht,ob das eine Rolle spielt.

Ergänzung von einem Ollama Nutzer:

Das Programm kann man im Chat mit „/bye“ beenden.

Stoppen von Ollama mit: sudo service ollama stop

Grafikkartennutzung von Ollama anzeigen mit: „ollama ps“ oder bei Nvidia Karten mit „nvidia-smi“

Weitere LLM’s installieren:

Bei https://ollama.com/search passendes Model suchen und downloaden wenn Ollama läuft mit „ollama pull [Model]“ z.B. „ollama pull dolphin-mistral“ für das unzensierte Dolphin Modell.

Dies funktioniert natürlich auch mit „ollama run dolphin-mistral“ wenn das Model gleich gestartet werden soll.

Ollama lässt sich per Terminal mit „ollama serve“ einfach starten.

Ich nutze Open-Webui mit Ollama und kann es jedem nur empfehlen.

Wäre schön, wenn außer englisch auch andere sprachen einstellbar weren z.B. deutsch