Die meisten, die hier schon länger mitlesen, oder auch mitmachen – kennen mich, ich schreibe ja auch so einige Bücher über Linux – siehe Link oben. Nun, ich wollte über meinen Verlag ein Buch schreiben – über KI unter Linux, leider ist laut Verlag das Interesse für KI unter Linux wohl zu gering – der Verlag muss natürlich auch Geld einnehmen. Darum geht es eben auf der Linux Bibel rund 🙂.

Nun, viele nutzen KI unterschiedlich – die meisten KI-Anwendungen, sagen wir einmal lieber Chatbots im Netz sind mehr oder weniger intelligent. Die meisten dieser Dienste sind vor allem allgemein – sagen wir einmal allgemein gebildet, so kommt es auch gerne einmal zu Verwirrungen, nicht immer richtigen Antworten. Da wäre es doch interessant, sich einfach die KI zu nehmen und dieser zu zeigen, was sie sich ansehen/lernen soll. Im besten Fall soll diese auch noch lokal installiert sein – also die gelernten Daten nicht im Netz verbreiten – ideal für Unternehmen. Aber ich könnte auch als privater User der KI beispielsweise ein digitales Buch vor die Nase werfen und sagen – lies es und beantworte mir Fragen aus diesem.

An und für sich ist es gar nicht so schwierig, einer beliebigen künstlichen Intelligenz etwas beizubringen – hier müsste man sich mit dieser aber natürlich befassen. Dify ist nun nicht direkt selbst KI, sondern eine grafische Oberfläche, mit der man KI etwas beibringen kann und diese dann natürlich auch befragen. Alles, ohne sich lange mit der Technik dahinter zu befassen.

Wir sehen uns diese Software in diesem Beitrag etwas näher an. Gleich einmal zu Beginn – ich bin heute zeitlich etwas eingeschränkt und weiß nicht, ob ich den Artikel heute auch fertigbringe, wenn nicht – in den nächsten Tagen.

Dify installieren

Grundsätzlich einmal – die Software benötigt für sich selbst etwa 2 Gigabyte Speicherplatz, zwei CPU-Kerne und 4 Gigabyte RAM. Zusätzlich benötigen Sie noch Platz für die eigentliche KI – siehe etwa Ollama. Sie können aber auch andere, nicht lokale KI nutzen. Installiert wird die Software am einfachsten über Docker oder Podman (siehe auch entsprechende Artikel auf der Linux Bibel.

Die Beschreibung gilt für Debian (in meinem aktuellen Fall Debian 12), sollte also auch problemlos unter Derivaten wie Ubuntu und Co. funktionieren (hier geht es vor allem um Pakete, die zu installieren sind). Unter Debian installieren Sie erst einmal über die Paket-Verwaltung folgende Pakete – eine grafische Oberfläche ist nicht nötig: „docker.io docker-compose git“ oder eben die entsprechenden Podman-Pakete.

Jetzt wird als Erstes alles nötige heruntergeladen, gleich mal alles am Terminal (erst als normaler Benutzer) – wir laden die Konfiguration herunter:

git clone https://github.com/langgenius/dify.gitWir wechseln in das heruntergeladene Git-Repo:

cd difyJetzt erstellen wir die Konfiguration der Software:

cp .env.example .envGrundsätzlich wäre es dies schon gewesen – ohne weitere Konfiguration läuft die Software zum Testen schon so. Für den produktiven Betrieb sollten Sie sich die versteckte Konfigurationsdatei „.env“ aber doch einmal mit einem Editor ansehen und bearbeiten – vor allem Volumes oder Mounts, damit Daten auch gespeichert werden – siehe Beiträge auf der Linux Bibel. Bisher haben wir nur die Konfiguration für den Container und die Software, die eigentliche Software laden wir uns als root herunter und starten den Container mit dem Befehl:

docker-compose up -dOder eben:

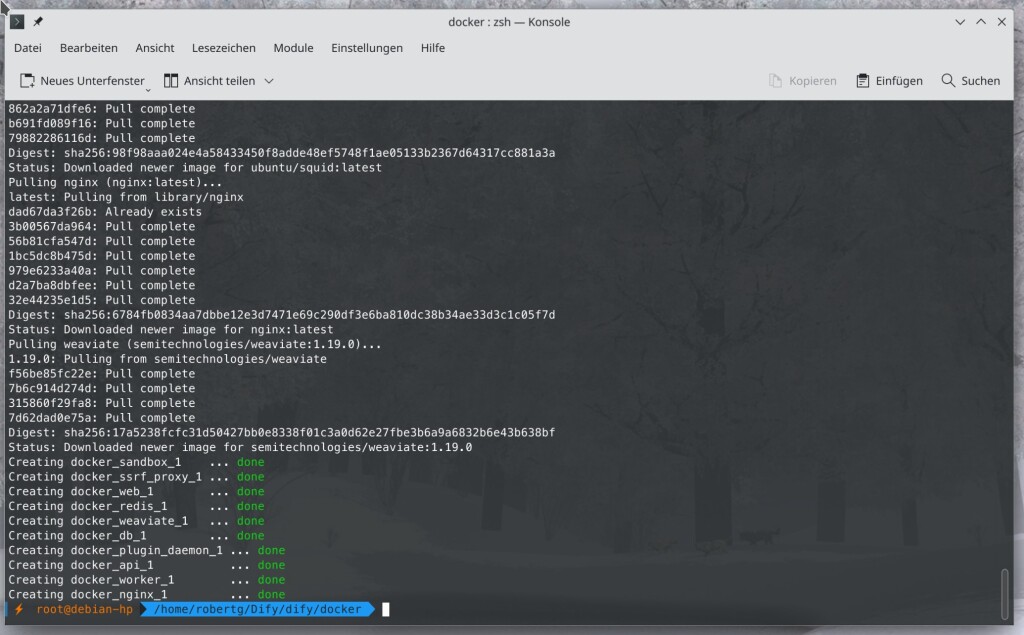

podman-compose up -dBei mir hat der Download etwa zwei Minuten gedauert, wie schon beschrieben etwa 2 GB. Am Ende sollten Sie keine Fehlermeldungen erhalten, wie etwa hier:

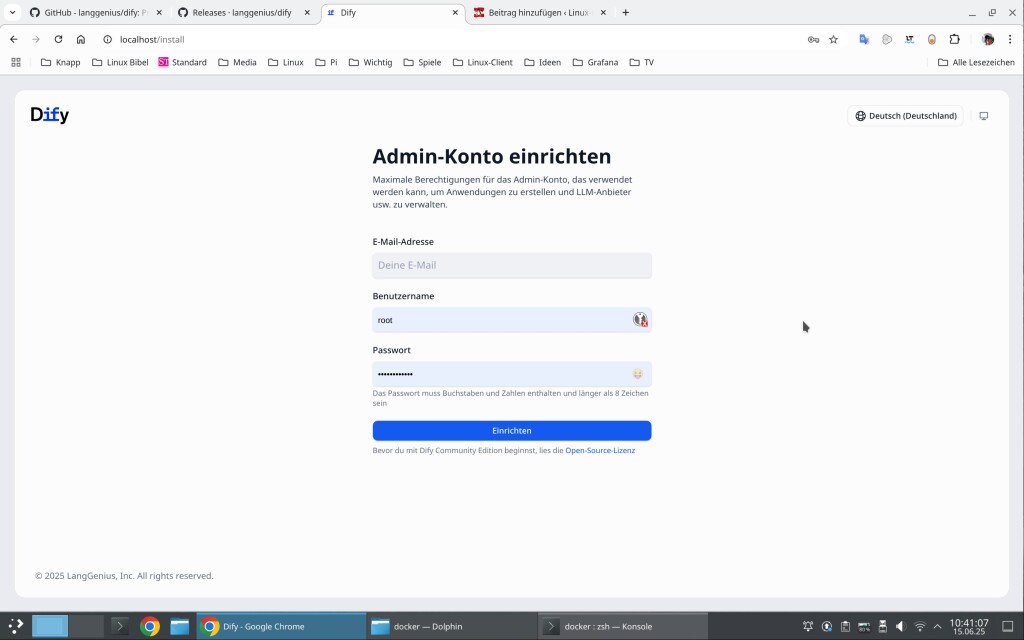

Jetzt öffnen wir die Software im Webbrowser, lokal mit der Adresse http://localhost/install:

Geben Sie Ihre Mail-Adresse, einen Benutzernamen und ein Passwort an, klicken auf „Einrichten“ und melden sich anschließend an:

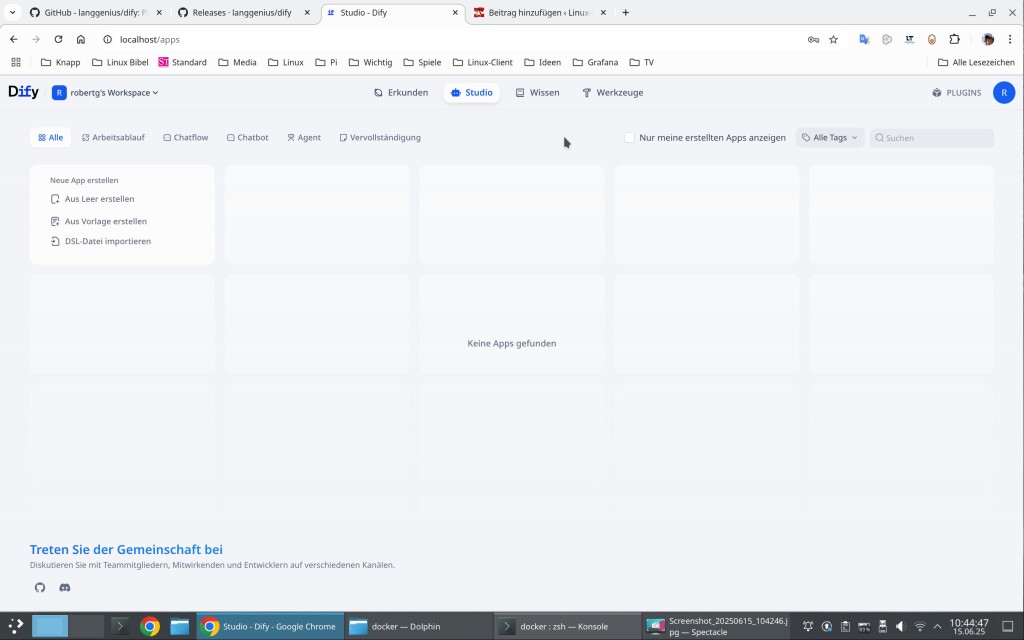

Schon befinden wir uns in der grafischen Oberfläche zur Einrichtung der Software. Wir sehen hier gleich einmal – mit dem Terminal brauchen wir uns nicht mehr zu befassen, nur zum Starten und Beenden. Wir befinden uns erst einmal im Studio – dies zeigt sich in der Leiste in der Mitte oben.

Wollen wir uns einmal ansehen, wie die Software arbeitet, bleiben wir im Studio, in der Liste darunter auf der linken Seite klicken wir auf den „Chatbot“ und hier „Aus Leer erstellen„:

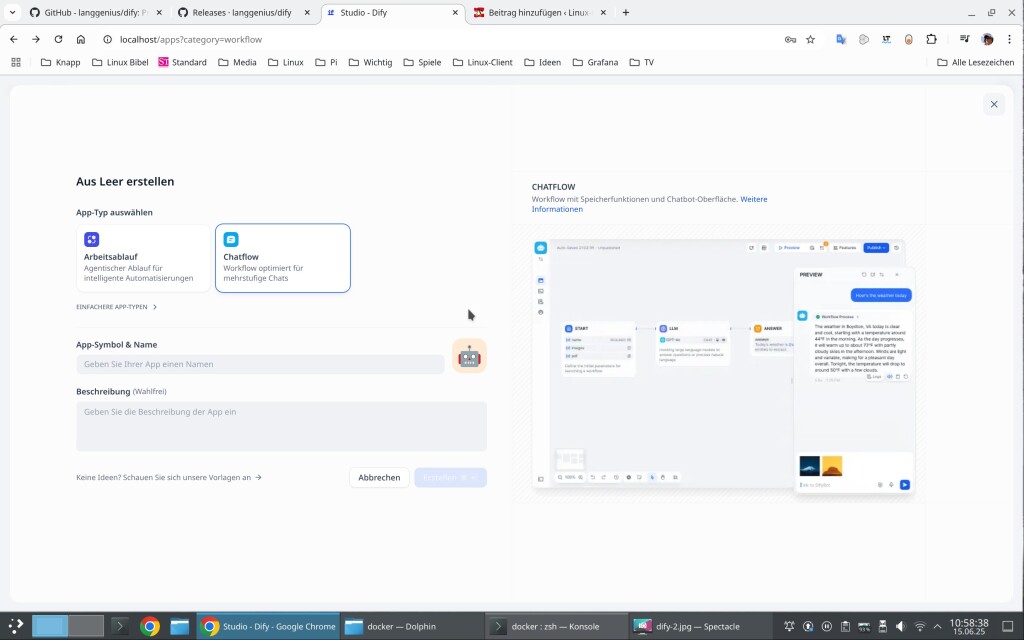

Wir bleiben auf dem markierten „Chatflow“ und geben dem Chatbot einen Namen, wenn gewünscht auch darunter eine Beschreibung, anschließend klicken wir auf „Erstellen“ darunter:

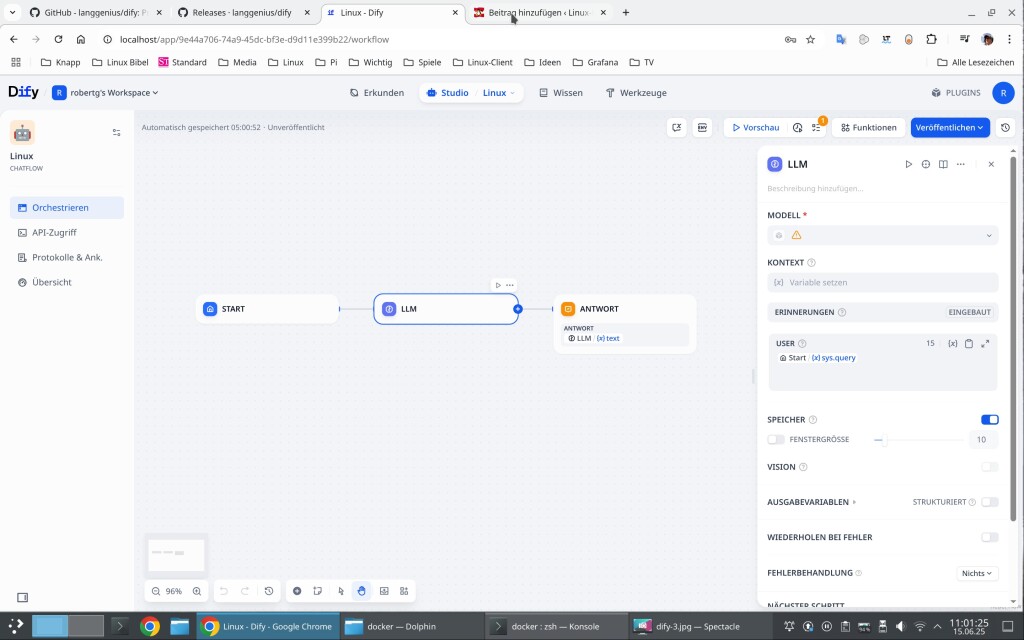

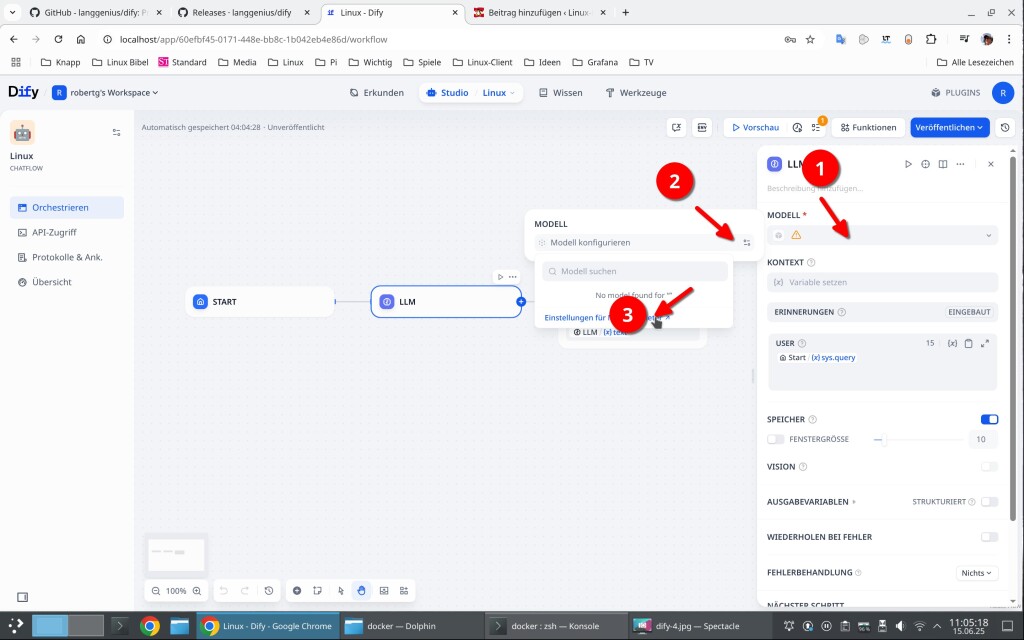

Die Software bringt uns zu den Einstellungen – im Feld in der Mitte finden Sie Felder, „Start„, „LLM“ und „Antwort“ – klicken Sie auf ein Feld, finden Sie die passenden Einstellungen dazu rechts. Unter „LLM“ wird natürlich das Sprachmodell ausgewählt:

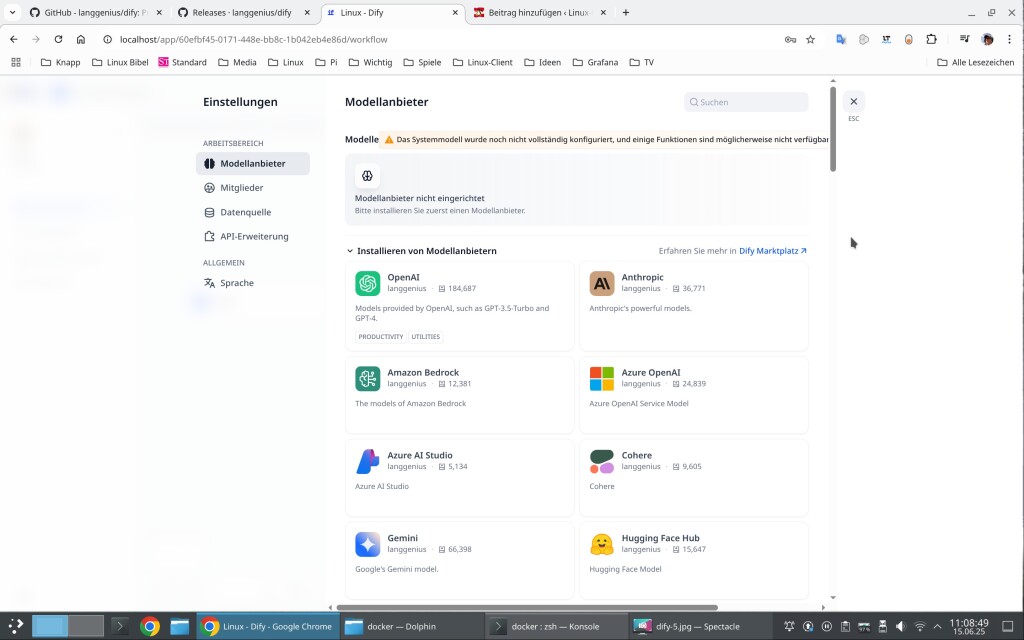

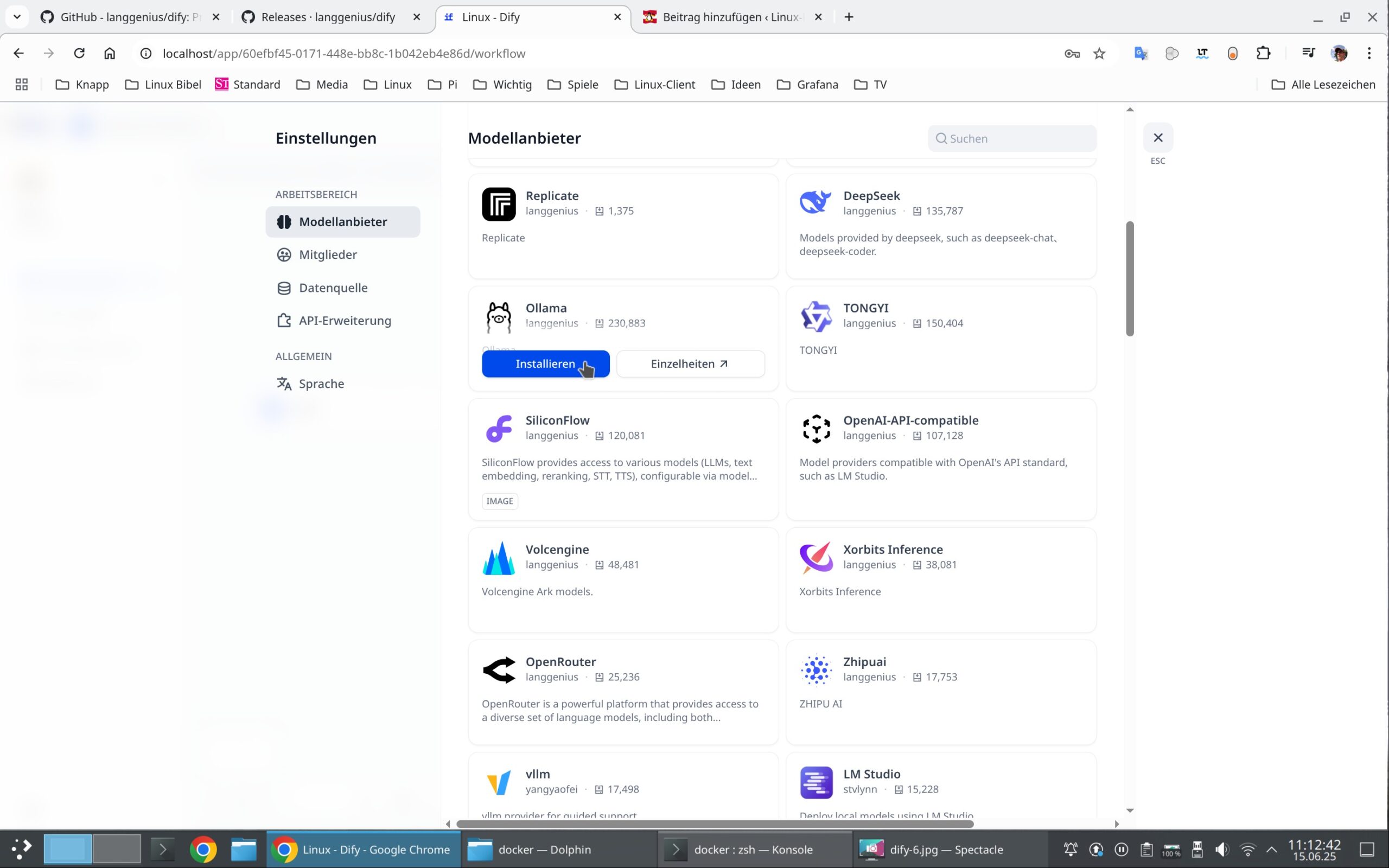

Klicken Sie sich durch die Links und anschließend auf „Einstellungen für Modellanbieter„, Sie erhalten eine Liste der aktuell bereits möglichen KI-Sprachmodelle:

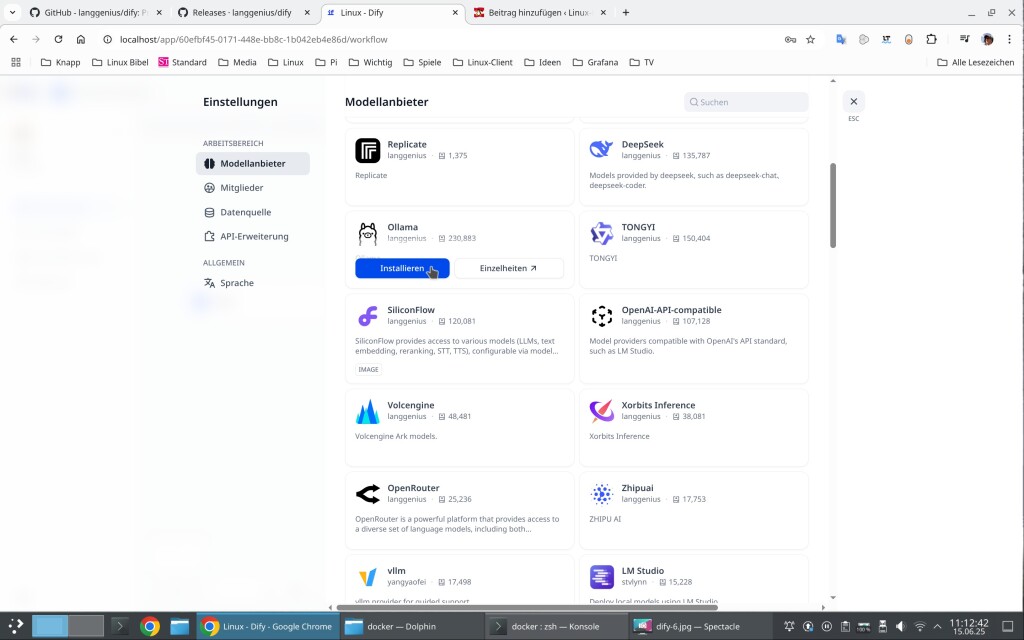

Hier finden Sie nicht nur bereits online verfügbare Online-KI, sondern, wenn Sie etwas runterscrollen, etwa auch Ollama, mit dem Sie unter Linux lokal Sprachmodelle ganz einfach installieren können. Einfach auswählen und auf „Installieren“ klicken:

Im sich öffnenden kleinen Fenster klicken Sie zur Bestätigen nochmals auf „Installieren„, dies kann einige Sekunden dauern, warten Sie ab, bis das Fenster geschlossen wird.

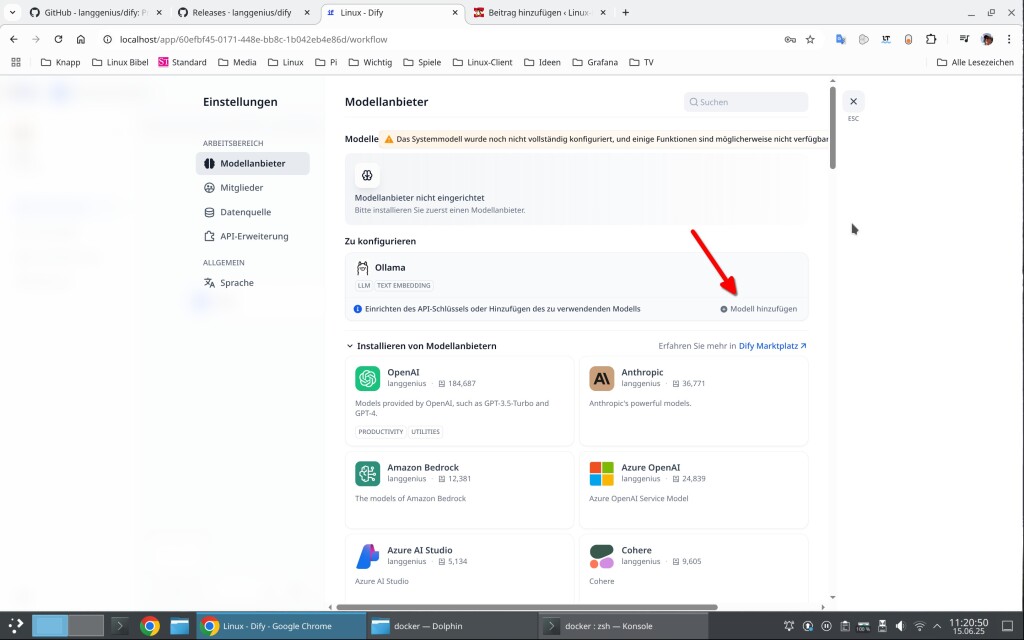

Damit wurde jedoch nicht Ollama installiert, sondern das Plugin, mit dem Dify mit der gewünschten KI kommuniziert. Die KI muss online erreichbar sein (ChatGPT und Co.), oder wie etwa bei Ollama üblich auf einem erreichbaren oder auf dem lokalen Rechner installiert sein und aktiv sein – das Sprachmodell natürlich auch. Nachdem das Plugin installiert wurde, klicken Sie bei diesem auf den Schalter „Modell hinzufügen„:

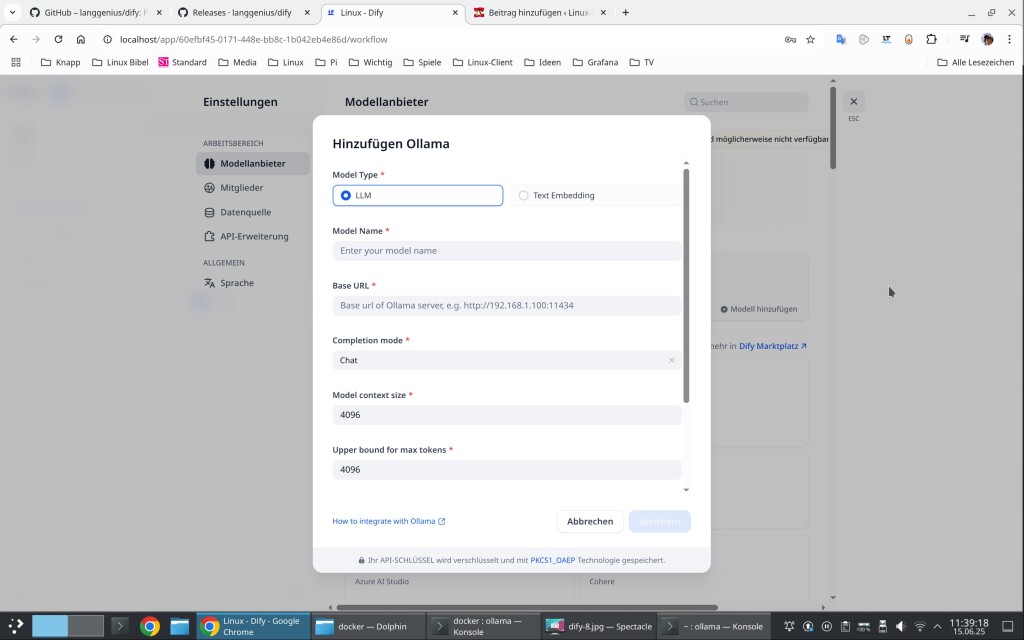

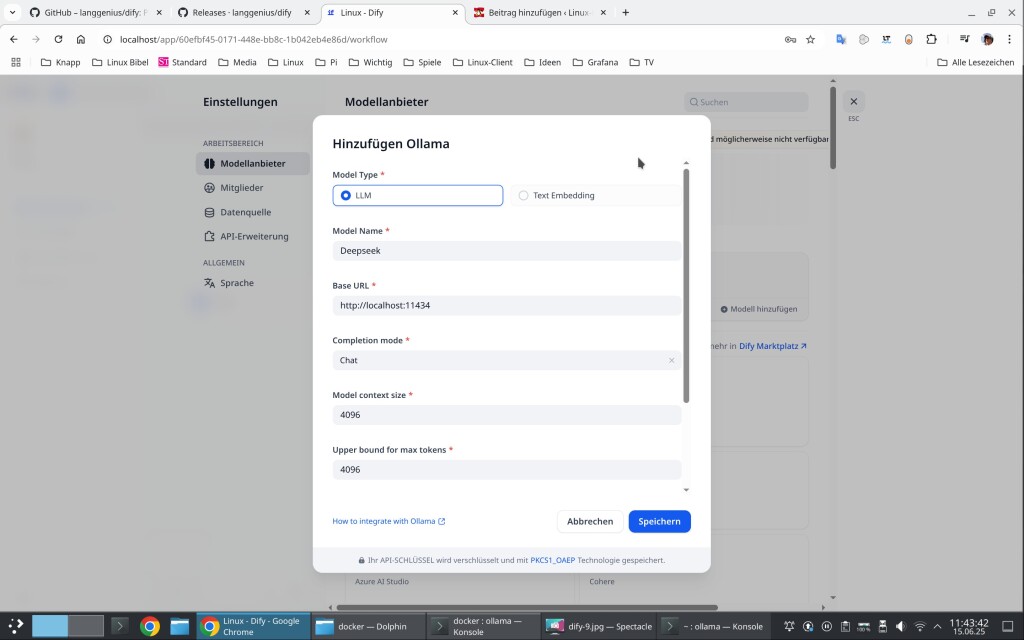

Hier geben Sie jetzt je nach Modell die entsprechenden Daten ein:

Für Ollama am lokalen Host installiert etwa:

Wichtig – dadurch, dass Docker / Podman nicht direkt auf den lokalen Rechner – also auch auf Ollama nicht zugreifen kann, geben Sie statt „localhost“ die IP-Adresse des Hosts an.

Der Artikel wird demnächst vervollständigt.

Noch keine Reaktion