Ollama lässt sich auch mit grafischer Oberfläche unter Linux nutzen, die Software nennt sich Open WebUI. Zur Installation nutzen Sie Docker oder Podman. Ollama installieren Sie wie am ersten Link und lassen es via Systemd laufen.

Wie Sie Docker nutzen, lesen Sie unter oben genannten Link, Podman nutzen Sie auf dieselbe Art – Podman wird jedoch weiterentwickelt, während Docker (bis auf die Docker Registry) so gesehen tot ist.

Wollen wir erst einmal das WebUI-Image herunterladen:

docker pull ghcr.io/open-webuiPodman:

podman pull ghcr.io/open-webuiJetzt können wir Open WebUI starten:

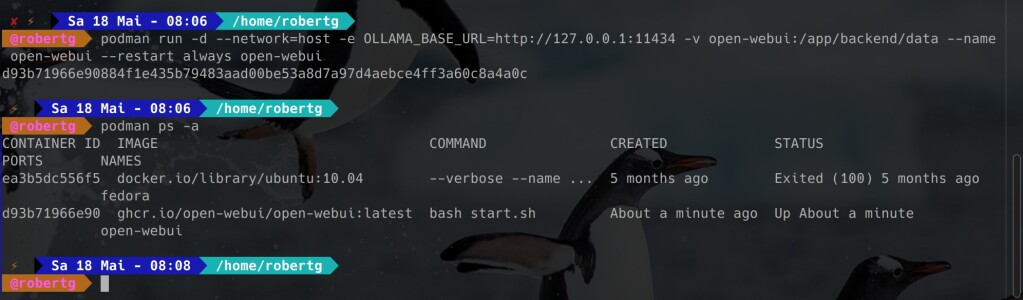

podman run -d --network=host -e OLLAMA_BASE_URL=http://127.0.0.1:11434 -v open-webui:/app/backend/data --name

open-webui --restart always open-webuidocker run -d --network=host -e OLLAMA_BASE_URL=http://127.0.0.1:11434 -v open-webui:/app/backend/data --name

open-webui --restart always open-webuiMit einem:

docker ps -a

podman ps -alässt sich prüfen, ob die Software läuft:

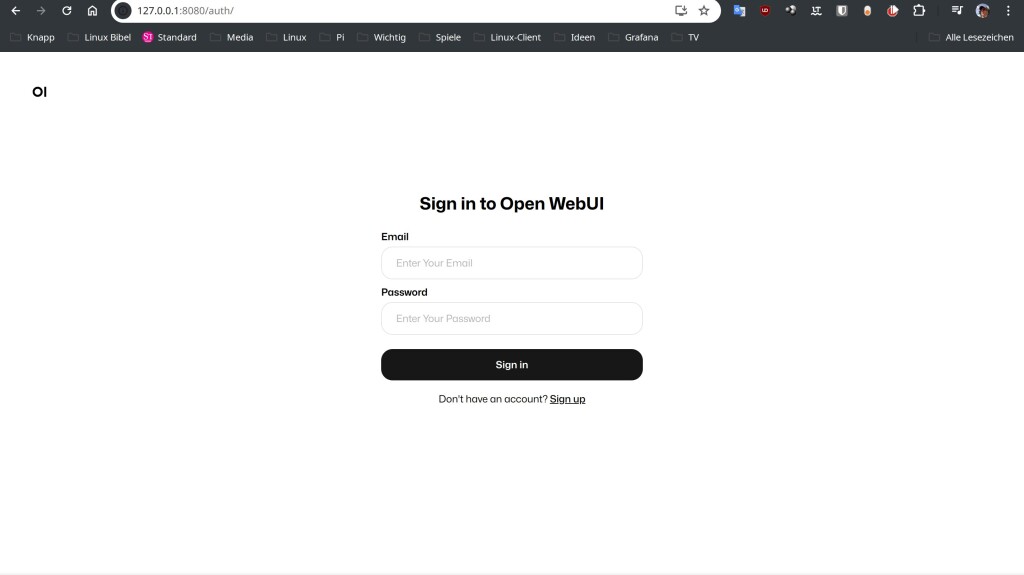

Jetzt öffnen Sie den Webbrowser mit der Adresse 127.0.0.1:8080:

Sie klicken auf den Schalter „Sign up„, geben Ihre Mail-Adresse an und erstellen ein Passwort für den Admin-Account:

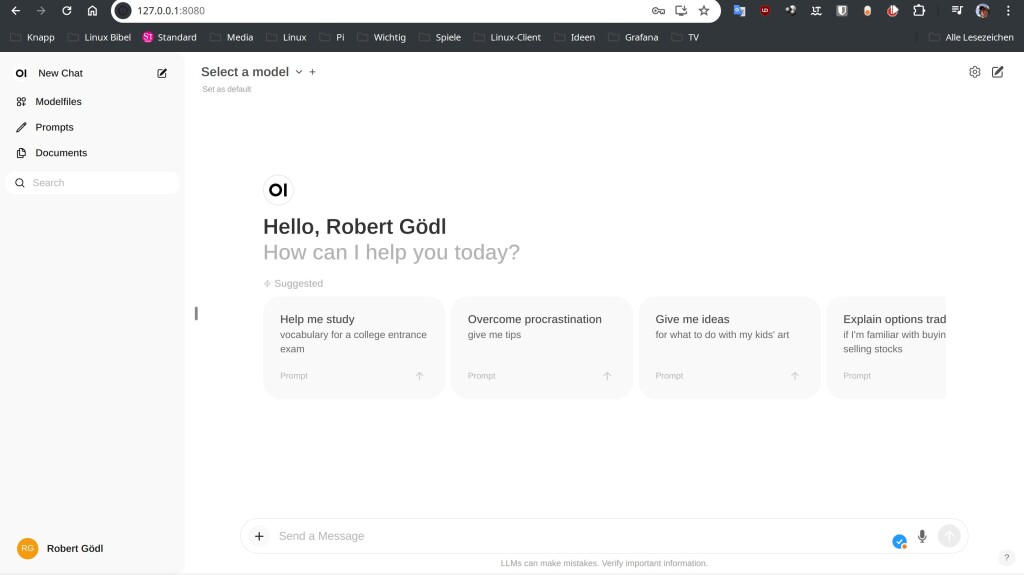

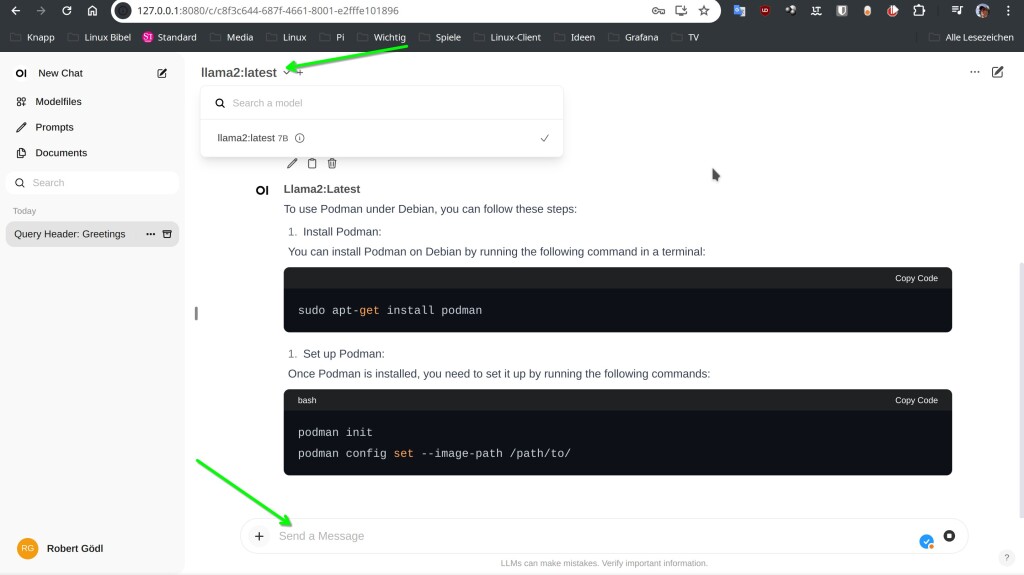

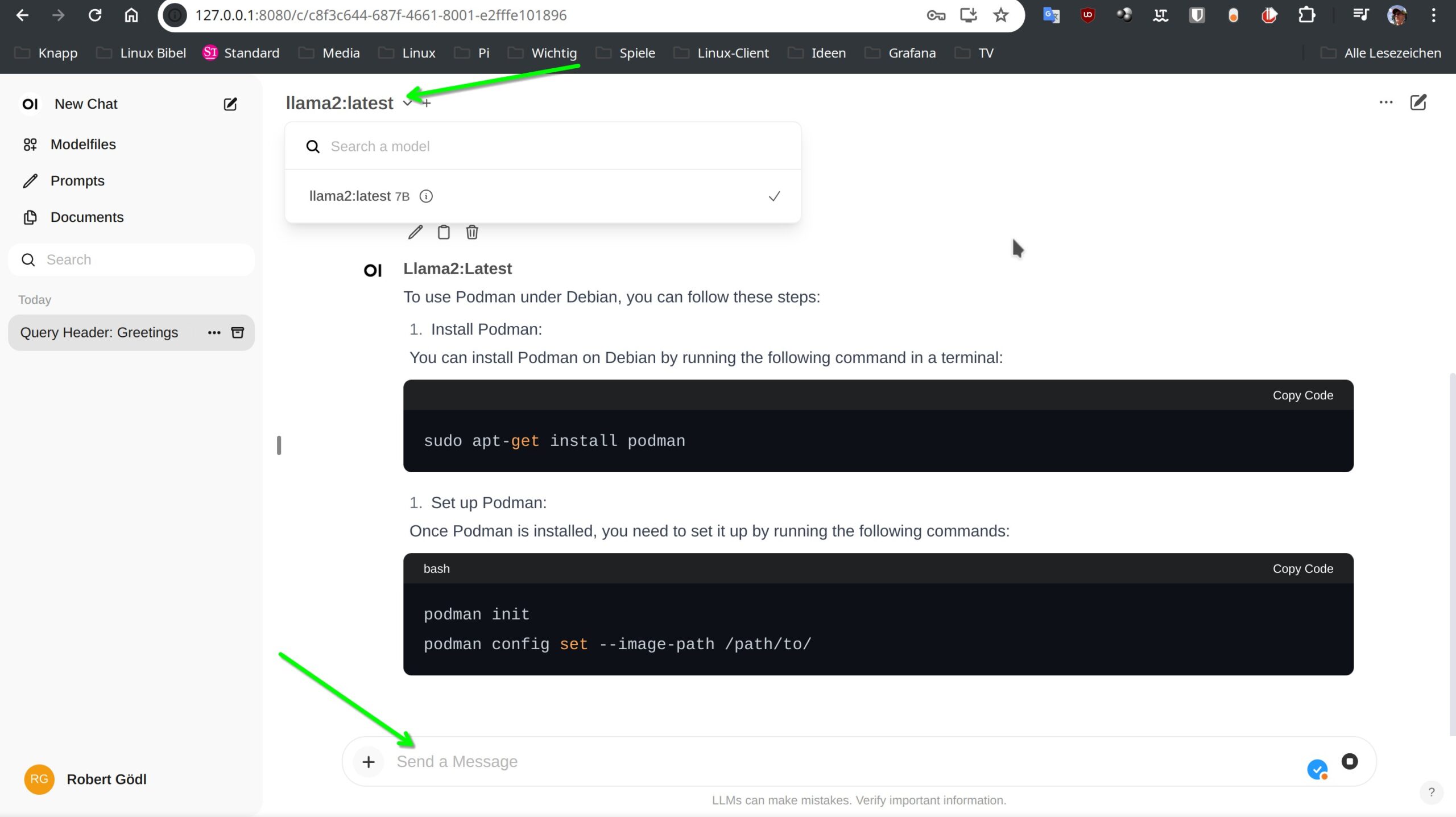

Schon finden Sie sich in Ihrer lokalen grafischen Oberfläche für Ihre KI wieder. Oben mittig links klicken Sie auf den Pfeil „Select a model“ und wählen das bereits aktive llama2 und können schon los chatten:

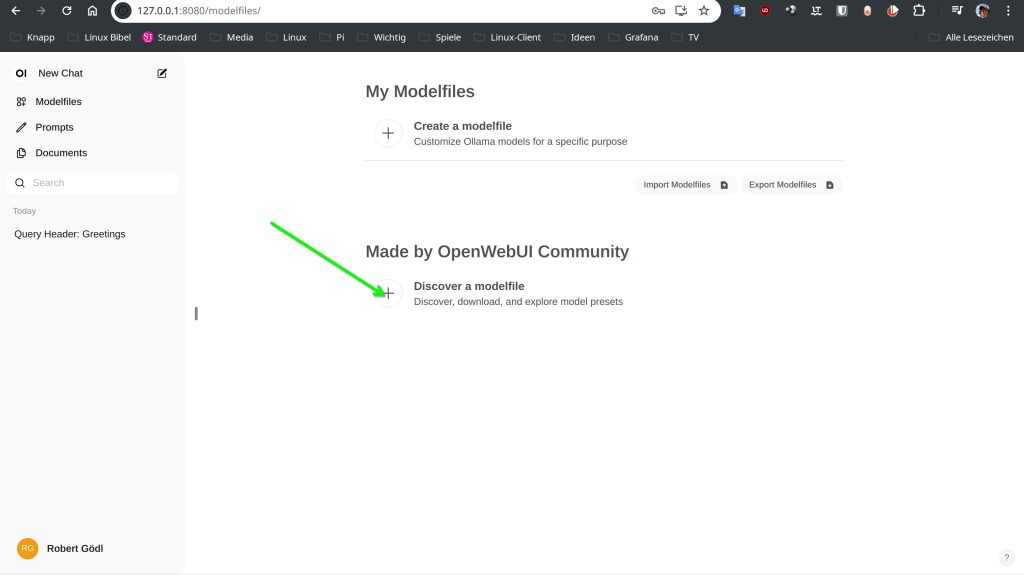

Über die Liste links → Modelfiles können Sie weitere Sprachmodelle, Bildgeneratoren und so weiter und so fort installieren:

Bei meinem Test war die Seite allerdings gerade nicht erreichbar :). Die volle Dokumentation zur Software finden Sie unter Open WebUI.

Schließen Sie den Browser-Tab – beendet sich auch die laufende KI. Möchten Sie Open WebUI wieder los werden:

podman stop open-webui

docker stop open-webuipodman rm -f open-webui

docker rm -f open-webuipodman volume rm open-webui

docker volume rm open-webui

Noch keine Reaktion